- होम

- लेटेस्ट न्यूज़

SSC Stenographer Admit Card 2025: एसएससी स्टेनोग्राफर इंटीमेशन स्लिप जारी, जानें कब से डाउनलोड कर पाएंगे एडमिट कार्ड

SSC Stenographer Admit Card 2025: एसएससी स्टेनोग्राफर इंटीमेशन स्लिप जारी, जानें कब से डाउनलोड कर पाएंगे एडमिट कार्ड Workout Reduce Cancer Risk: रोजाना सिर्फ एक वर्कआउट से कैंसर का खतरा 30% कम! जानिए नई रिसर्च क्या कहती है

Workout Reduce Cancer Risk: रोजाना सिर्फ एक वर्कआउट से कैंसर का खतरा 30% कम! जानिए नई रिसर्च क्या कहती है HP Police Result 2025: हिमाचल प्रदेश पुलिस कांस्टेबल भर्ती परीक्षा का रिजल्ट जारी, hppsc.hp.gov.in पर ऐसे करें चेक

HP Police Result 2025: हिमाचल प्रदेश पुलिस कांस्टेबल भर्ती परीक्षा का रिजल्ट जारी, hppsc.hp.gov.in पर ऐसे करें चेक जम्मू-कश्मीर में चौथे दिन भी सेना का 'ऑपरेशन अखल' जारी, एक और आतंकवादी ढेर

जम्मू-कश्मीर में चौथे दिन भी सेना का 'ऑपरेशन अखल' जारी, एक और आतंकवादी ढेर अमरनाथ यात्रा करने के इच्छुक लोगों के लिए बुरी खबर, इस साल तय समय से पहले ही स्थगित कर दी गई, क्या है असली वजह?

अमरनाथ यात्रा करने के इच्छुक लोगों के लिए बुरी खबर, इस साल तय समय से पहले ही स्थगित कर दी गई, क्या है असली वजह?

- वेब स्टोरीज

- भारत

जम्मू-कश्मीर में चौथे दिन भी सेना का 'ऑपरेशन अखल' जारी, एक और आतंकवादी ढेर

जम्मू-कश्मीर में चौथे दिन भी सेना का 'ऑपरेशन अखल' जारी, एक और आतंकवादी ढेर ...तो हिमाचल प्रदेश देश के नक्शे से गायब हो जाएगा, सुप्रीम कोर्ट ने ऐसा क्यों कहा?

...तो हिमाचल प्रदेश देश के नक्शे से गायब हो जाएगा, सुप्रीम कोर्ट ने ऐसा क्यों कहा? UP News: ड्रोन से डर फैलाने वालों पर योगी सरकार का वार, NSA और गैंगस्टर एक्ट में होगी कार्रवाई

UP News: ड्रोन से डर फैलाने वालों पर योगी सरकार का वार, NSA और गैंगस्टर एक्ट में होगी कार्रवाई दो EPIC नंबर वाले वोटर आईडी को लेकर बुरे फंसे तेजस्वी यादव, चुनाव आयोग ने भेज दिया नोटिस

दो EPIC नंबर वाले वोटर आईडी को लेकर बुरे फंसे तेजस्वी यादव, चुनाव आयोग ने भेज दिया नोटिस उपराष्ट्रपति चुनाव को लेकर शशि थरूर का इशारा किस ओर? मोदी सरकार से जताई ये खास उम्मीद

उपराष्ट्रपति चुनाव को लेकर शशि थरूर का इशारा किस ओर? मोदी सरकार से जताई ये खास उम्मीद

- लाइफस्टाइल

Workout Reduce Cancer Risk: रोजाना सिर्फ एक वर्कआउट से कैंसर का खतरा 30% कम! जानिए नई रिसर्च क्या कहती है

Workout Reduce Cancer Risk: रोजाना सिर्फ एक वर्कआउट से कैंसर का खतरा 30% कम! जानिए नई रिसर्च क्या कहती है अमरनाथ यात्रा करने के इच्छुक लोगों के लिए बुरी खबर, इस साल तय समय से पहले ही स्थगित कर दी गई, क्या है असली वजह?

अमरनाथ यात्रा करने के इच्छुक लोगों के लिए बुरी खबर, इस साल तय समय से पहले ही स्थगित कर दी गई, क्या है असली वजह? Morning Tea: सुबह उठकर खाली पेट चाय पीना छोड़ दें तो क्या होगा? जानिए 30 दिन में क्या बड़े बदलाव शरीर में दिखने लगेंगे

Morning Tea: सुबह उठकर खाली पेट चाय पीना छोड़ दें तो क्या होगा? जानिए 30 दिन में क्या बड़े बदलाव शरीर में दिखने लगेंगे Chutney For Uric Acid Control: यूरिक एसिड के मरीज खाएं ये देसी चटनी, जोड़ों के दर्द और गठिया में मिलेगा आराम

Chutney For Uric Acid Control: यूरिक एसिड के मरीज खाएं ये देसी चटनी, जोड़ों के दर्द और गठिया में मिलेगा आराम  एक्ट्रेस संगीता बिजलानी ने TIGP 2025 ब्यूटी क्वीन्स को पहनाया ताज, जानें टीन से लेकर मिस और मिसेज इंडिया का ताज किसके सिर सजा?

एक्ट्रेस संगीता बिजलानी ने TIGP 2025 ब्यूटी क्वीन्स को पहनाया ताज, जानें टीन से लेकर मिस और मिसेज इंडिया का ताज किसके सिर सजा?

- मनोरंजन

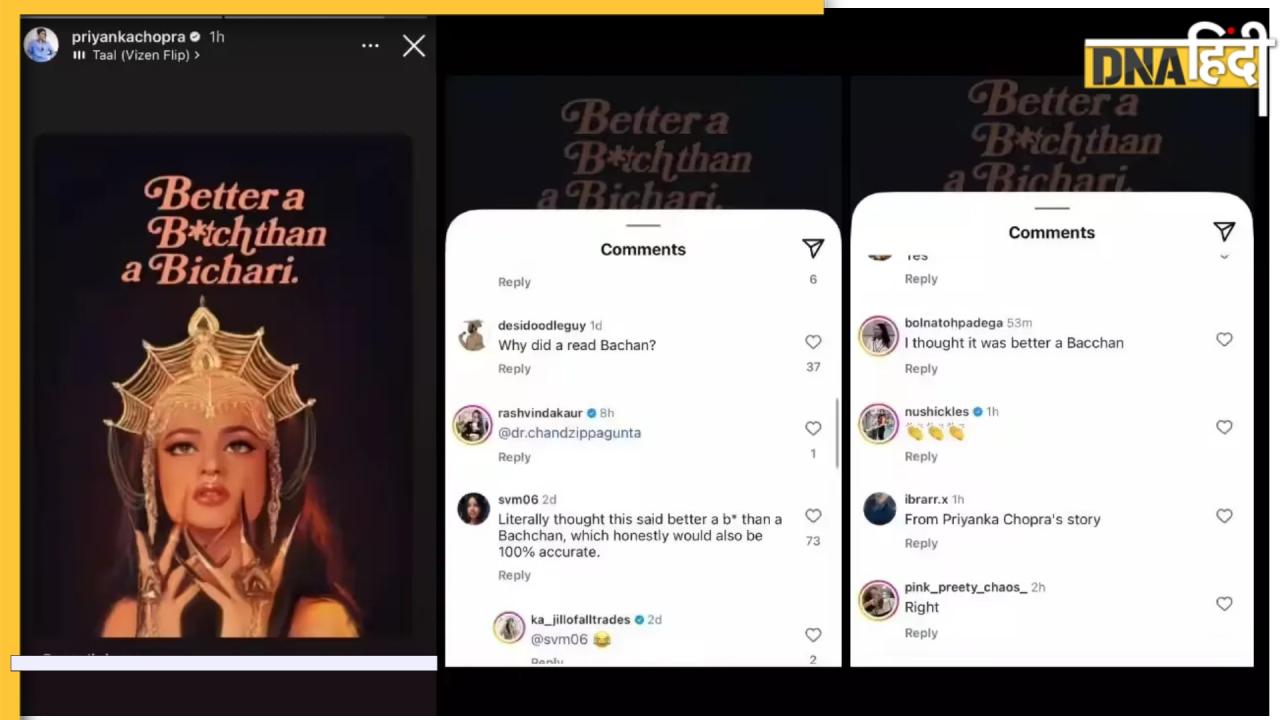

ओह मॉय गॉड... प्रियंका चोपड़ा ने रेखा के लिए सोशल मीडिया पर ये क्या लिख दिया ! इंस्टा पोस्ट देख हर कोई चौंक रहा

ओह मॉय गॉड... प्रियंका चोपड़ा ने रेखा के लिए सोशल मीडिया पर ये क्या लिख दिया ! इंस्टा पोस्ट देख हर कोई चौंक रहा जब राष्ट्रीय फिल्म पुरस्कार के लिए किशोर कुमार को आया था फोन, लेकिन इस एक शर्त ने पूरा खेल बिगाड़ दिया

जब राष्ट्रीय फिल्म पुरस्कार के लिए किशोर कुमार को आया था फोन, लेकिन इस एक शर्त ने पूरा खेल बिगाड़ दिया परिणीति चोपड़ा और राघव चड्ढा जल्द देने वाले हैं 'गुड न्यूज', कपिल के शो में कर दिया खुलासा!

परिणीति चोपड़ा और राघव चड्ढा जल्द देने वाले हैं 'गुड न्यूज', कपिल के शो में कर दिया खुलासा! 'कितना दिखावा करती है', Labubu की दीवानी हुईं उर्वशी रौतेला, फिर से फॉलो किया ट्रेंड, इस बार दिया ये ट्विस्ट

'कितना दिखावा करती है', Labubu की दीवानी हुईं उर्वशी रौतेला, फिर से फॉलो किया ट्रेंड, इस बार दिया ये ट्विस्ट Box office report: सन ऑफ सरदार या धड़क 2, ओपनिंग डे पर किस फिल्म ने की धांसू कमाई, यहां जानें

Box office report: सन ऑफ सरदार या धड़क 2, ओपनिंग डे पर किस फिल्म ने की धांसू कमाई, यहां जानें

- ट्रेंडिंग

जब टीचर ने पूछा, फोन क्यों नहीं देखना चाहिए? बच्चों ने दिए ऐसे जवाब, सुनकर हैरान रह जाएंगे आप! Video Viral

जब टीचर ने पूछा, फोन क्यों नहीं देखना चाहिए? बच्चों ने दिए ऐसे जवाब, सुनकर हैरान रह जाएंगे आप! Video Viral न डेस्क, न मीटिंग, ये 'महाराज' सिर्फ किचन से कर रहा है घंटों में लाखों की कमाई, वायरल पोस्ट ने उड़ाए लोगों के होश

न डेस्क, न मीटिंग, ये 'महाराज' सिर्फ किचन से कर रहा है घंटों में लाखों की कमाई, वायरल पोस्ट ने उड़ाए लोगों के होश अलविदा कहते हुए निभाया दोस्ती का वादा, वजह जान हो गया हर कोई भावुक अंतिम यात्रा में डांस का Video Viral

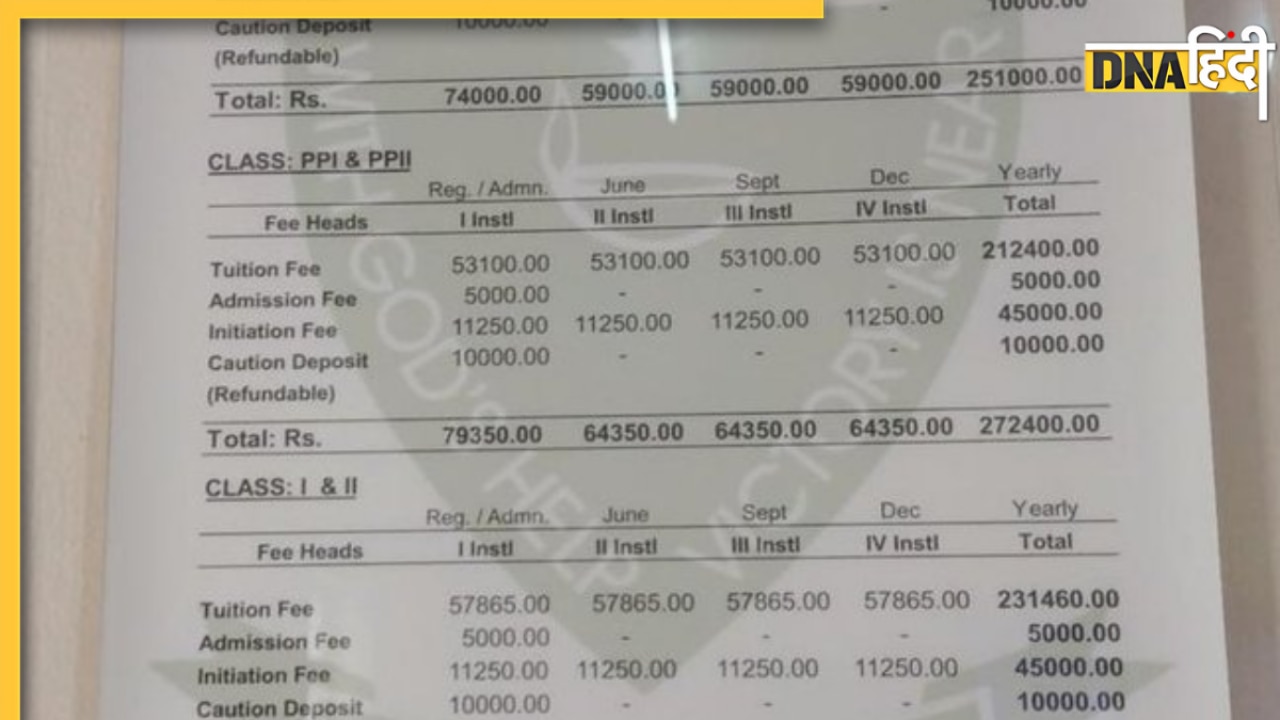

अलविदा कहते हुए निभाया दोस्ती का वादा, वजह जान हो गया हर कोई भावुक अंतिम यात्रा में डांस का Video Viral Viral News: ABCD सीखना है तो महीने के देने होंगे 21 हजार रुपये? नर्सरी की फीस देख लोगों के उड़े होश

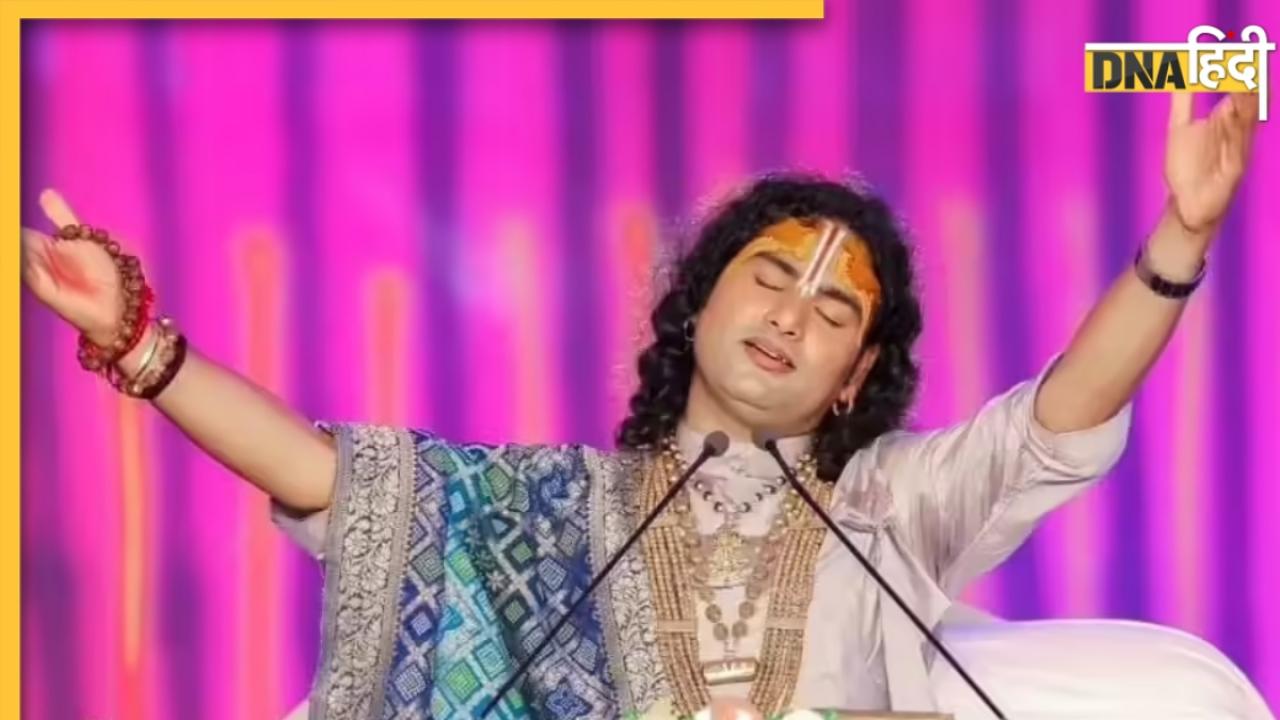

Viral News: ABCD सीखना है तो महीने के देने होंगे 21 हजार रुपये? नर्सरी की फीस देख लोगों के उड़े होश माधुरी दीक्षित के गाने की बीट पर कान्हा भजन, सुनते ही हंस पड़े प्रेमानंद जी महाराज, Video Viral

माधुरी दीक्षित के गाने की बीट पर कान्हा भजन, सुनते ही हंस पड़े प्रेमानंद जी महाराज, Video Viral

- स्पोर्ट्स

IND vs ENG 5TH Test Day 4 Highlights: बारिश के कारण दिन का खेल खत्म, मुश्किल में इंग्लैंड; जीत के लिए चाहिए 35 रन

IND vs ENG 5TH Test Day 4 Highlights: बारिश के कारण दिन का खेल खत्म, मुश्किल में इंग्लैंड; जीत के लिए चाहिए 35 रन Joe Root Century: ब्रूक के बाद जो रूट का शतक, दांव पर लगा सचिन तेंदुलकर का रिकॉर्ड; संगकारा को भी पछाड़ा

Joe Root Century: ब्रूक के बाद जो रूट का शतक, दांव पर लगा सचिन तेंदुलकर का रिकॉर्ड; संगकारा को भी पछाड़ा IND vs ENG: कैच पकड़ने के बाद कैसे मिला हैरी ब्रूक को छक्का? सिराज की एक गलती से हारेगी टीम इंडिया, मांगनी पड़ी माफी

IND vs ENG: कैच पकड़ने के बाद कैसे मिला हैरी ब्रूक को छक्का? सिराज की एक गलती से हारेगी टीम इंडिया, मांगनी पड़ी माफी IND vs ENG: अगर ड्रॉ हुई भारत-इंग्लैंड सीरीज, तो कहां रखी जाएगी एंडरसन-तेंदुलकर ट्रॉफी?

IND vs ENG: अगर ड्रॉ हुई भारत-इंग्लैंड सीरीज, तो कहां रखी जाएगी एंडरसन-तेंदुलकर ट्रॉफी? 'वो मुझसे बेहतर हैं...' सुनील गावस्कर के 54 साल पुराने रिकॉर्ड से भी बड़े हैं शुभमन गिल, पूर्व दिग्गज का बड़ा बयान

'वो मुझसे बेहतर हैं...' सुनील गावस्कर के 54 साल पुराने रिकॉर्ड से भी बड़े हैं शुभमन गिल, पूर्व दिग्गज का बड़ा बयान

- फोटो

फैट बर्नर पिल की तरह कमर और पेट की चर्बी जला देंगे ये फूड, 7 दिनों का ये वेजिटेरियन डाइट फॉलो करें

फैट बर्नर पिल की तरह कमर और पेट की चर्बी जला देंगे ये फूड, 7 दिनों का ये वेजिटेरियन डाइट फॉलो करें PPF में पैसे लगाकर हर महीने कमा सकते हैं 56 हजार रुपये, नहीं देना होगा कोई टैक्स, जानिए कैसे

PPF में पैसे लगाकर हर महीने कमा सकते हैं 56 हजार रुपये, नहीं देना होगा कोई टैक्स, जानिए कैसे Numerology: इन 4 तारीखों पर जन्मे लोग रातोंरात होते हैं मशहूर, वायरल गर्ल मोनालिसा की तरह चमकती है किस्मत

Numerology: इन 4 तारीखों पर जन्मे लोग रातोंरात होते हैं मशहूर, वायरल गर्ल मोनालिसा की तरह चमकती है किस्मत किसी से भी दोस्ती करने में नहीं होगी हिचकिचाहट, अपनाएं ये 5 असरदार तरीके

किसी से भी दोस्ती करने में नहीं होगी हिचकिचाहट, अपनाएं ये 5 असरदार तरीके नहीं मिल रही है नौकरी, तो अपनाएं ये 5 टिप्स; तुरंत आएगा ऑफर लेटर

नहीं मिल रही है नौकरी, तो अपनाएं ये 5 टिप्स; तुरंत आएगा ऑफर लेटर

- धर्म

अमरनाथ यात्रा करने के इच्छुक लोगों के लिए बुरी खबर, इस साल तय समय से पहले ही स्थगित कर दी गई, क्या है असली वजह?

अमरनाथ यात्रा करने के इच्छुक लोगों के लिए बुरी खबर, इस साल तय समय से पहले ही स्थगित कर दी गई, क्या है असली वजह? Sawan Akhiri Somwar: सावन का आखिरी सोमवार और प्रदोष पर शिवलिंग पर चढ़ाएं ये चीजें, दूर होंगी सारे ग्रहदोष और विपदाएं

Sawan Akhiri Somwar: सावन का आखिरी सोमवार और प्रदोष पर शिवलिंग पर चढ़ाएं ये चीजें, दूर होंगी सारे ग्रहदोष और विपदाएं Rashifal 04 August 2025: कर्क और धनु वाले सेहत का रखें खास ध्यान, जानें आज मेष से मीन तक की राशियों का भाग्यफल

Rashifal 04 August 2025: कर्क और धनु वाले सेहत का रखें खास ध्यान, जानें आज मेष से मीन तक की राशियों का भाग्यफल  Aniruddhacharya के पिता की योगी-मोदी से इंसाफ की गुहार! कहा बेटे के आश्रम में मेरे साथ गलत हो रहा, जानिए क्या है मामला

Aniruddhacharya के पिता की योगी-मोदी से इंसाफ की गुहार! कहा बेटे के आश्रम में मेरे साथ गलत हो रहा, जानिए क्या है मामला Rakshabandhan: राखी बांधते समय क्यों लगानी चाहिए 3 गांठ? जान लें राखी का शुभ मुहूर्त और राखी की थाली में क्या कुछ होना चाहिए

Rakshabandhan: राखी बांधते समय क्यों लगानी चाहिए 3 गांठ? जान लें राखी का शुभ मुहूर्त और राखी की थाली में क्या कुछ होना चाहिए

- सेहत

Workout Reduce Cancer Risk: रोजाना सिर्फ एक वर्कआउट से कैंसर का खतरा 30% कम! जानिए नई रिसर्च क्या कहती है

Workout Reduce Cancer Risk: रोजाना सिर्फ एक वर्कआउट से कैंसर का खतरा 30% कम! जानिए नई रिसर्च क्या कहती है Sugar Remedy: इस पेड़ की पत्तियों में है ब्लड शुगर कंट्रोल करने की ताकत, जानें इस्तेमाल का तरीका

Sugar Remedy: इस पेड़ की पत्तियों में है ब्लड शुगर कंट्रोल करने की ताकत, जानें इस्तेमाल का तरीका Desi Drink For Uric Acid: नुस्खा नहीं, इस देसी ड्रिंक को मानते हैं यूरिक एसिड का रामबाण इलाज! घर पर ऐसे बनाएं

Desi Drink For Uric Acid: नुस्खा नहीं, इस देसी ड्रिंक को मानते हैं यूरिक एसिड का रामबाण इलाज! घर पर ऐसे बनाएं Cat Scratch Disease: क्या होता है कैट स्क्रैच डिजीज? शरीर ही नहीं, दिमाग पर भी असर डालती है ये बीमारी

Cat Scratch Disease: क्या होता है कैट स्क्रैच डिजीज? शरीर ही नहीं, दिमाग पर भी असर डालती है ये बीमारी Oldest Frozen Embryo Baby: विज्ञान का चमत्कार! 1994 में स्टोर किए गए भ्रूण से 30 साल बाद जन्मा दुनिया का सबसे 'बुजुर्ग नवजात'

Oldest Frozen Embryo Baby: विज्ञान का चमत्कार! 1994 में स्टोर किए गए भ्रूण से 30 साल बाद जन्मा दुनिया का सबसे 'बुजुर्ग नवजात'

)

)

)

)

)

)

)

)

)

)

)

)

)

)

)